KDDIは7月4日20時から緊急のオンライン記者会見を開催した。7月2日未明から続いた大規模な通信障害について、7月3日11時に高橋誠社長が会見を開き、同日中の復旧作業終了予定を発表したが、その後もネットワークの負荷は十分に軽減できず、50%の流量制御などの対処を講じながらネットワークの試験・検証を行いつつ、音声通話が利用しづらい状況が長時間にわたり続いた。4日の会見では、5日夕刻をめどに完全復旧を目指すとともに、新たに全国に18台あるVoLTE交換機のうち、6台の切り離しを実施していたことが明らかになった。

KDDI 取締役執行役員専務の吉村和幸技術統括本部長(右)と

執行役員 技術統括本部の山本和弘副統括本部長 兼 エンジニアリング推進本部長

(7月4日20時のオンライン会見)

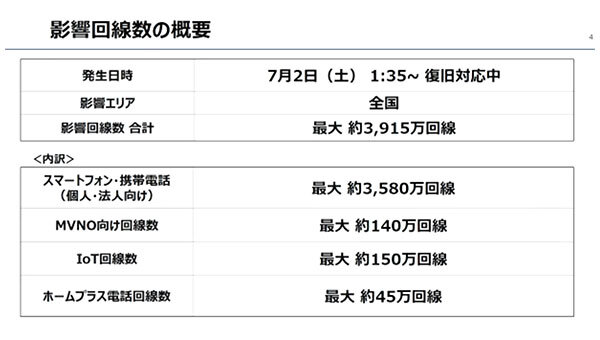

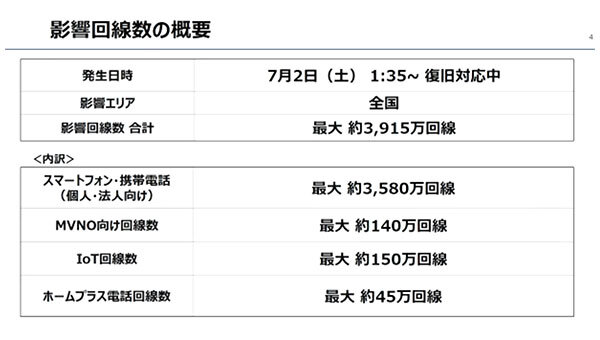

最大約3925万回線に影響(7月3日発表)

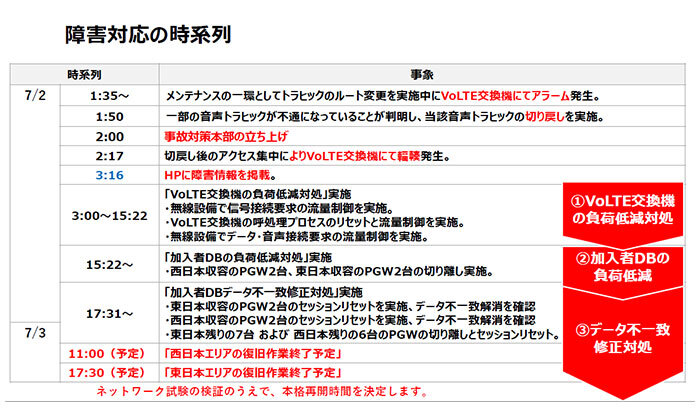

その後、音声トラヒックの切り戻しを実施した後にアクセスが集中し、利用者のスマートフォンなどからの再接続要求が多発したことも重なり、VoLTE交換機で通信が集中・混雑する輻輳(ふくそう)という現象が発生。全国規模の通信障害に広がった。KDDIは、3時16分にホームページで障害情報を発表した。

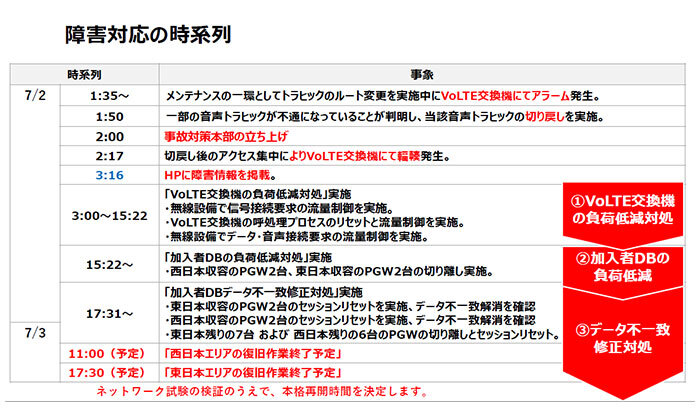

対応の時系列(7月3日発表)

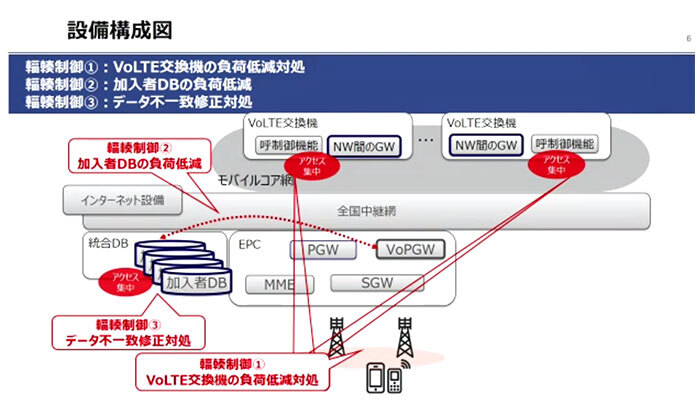

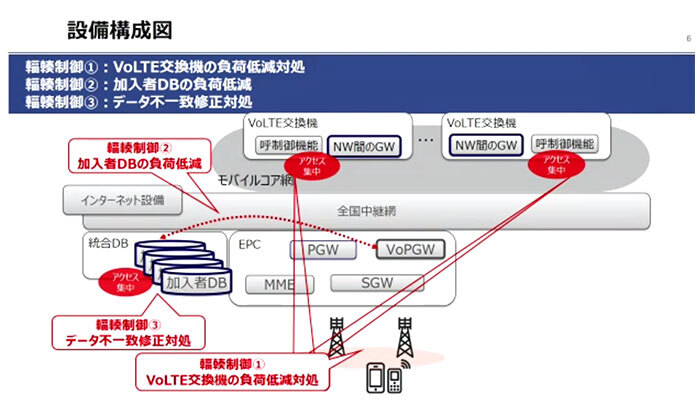

全国に18台あるVoLTE交換機の負荷を低減するための対処を実施し、「これをすればなんとかネットワークが戻るだろうということで行った。しかし、15時22分に、VoLTE交換機の負荷低減ではおさまらず、加入者DBもあふれて負荷低減作業を行った。17時31分に、加入者DB(データベース)のデータ不一致が原因であることがわかってきたため、データ不一致の修正対処を行い、なんとか少しづつ復旧してきている」と、高橋誠社長は7月3日11時の会見で語っている。

1拠点のコアルーターの交換作業をきっかけとし、VoLTE交換機のトラヒック集中、加入者DBのデータ不一致と次々にトラブルが広がっていった様子がわかる。

設備構成図(7月3日発表)

3日の会見では、11時に西日本、17時30分に東日本エリアの復旧作業終了予定を発表した。なお、西日本エリアを先行したのは、通信障害で緊急通報(110番、118番、119番)がつながらなくなり、沖縄地方に台風が上陸していたことから、首相官邸の意向を受けた総務省からの指示があったことを明らかにしている。

この復旧作業終了は、復旧のための作業が終わったということでネットワーク環境が元に戻ったことを意味しなかった。引き続き、ネットワークへのデータ流入を50%制限する流量制御を行いながら、試験や検証を行っていたためデータ通信や音声通話がつながりにくい状況は続いた。この点は「復旧作業終了」という言葉をめぐって、ユーザーの受け止め方との違いが生じてしまい、KDDIのアナウンスの仕方に問題があったと言えるだろう。

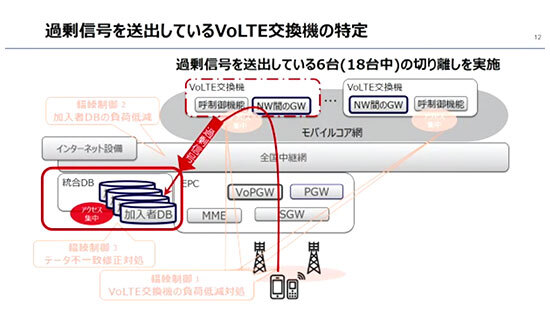

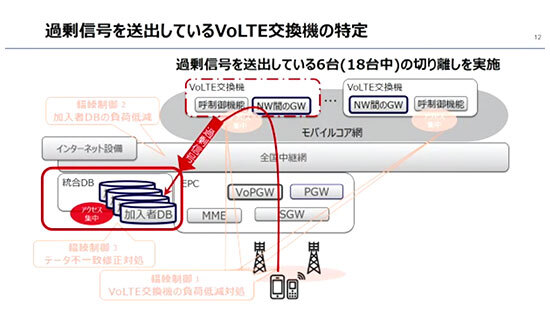

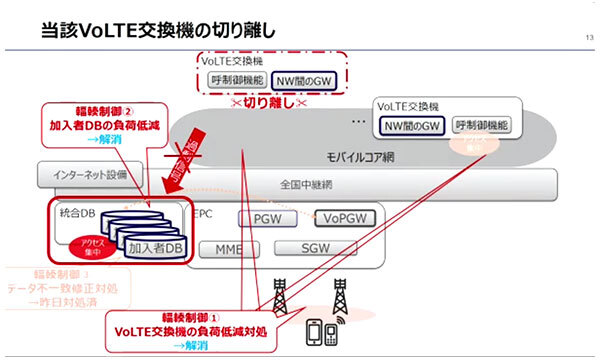

流量制御をしながら18台のVoLTE交換機の健全性を検証した結果、6台のVoLTE交換機から過剰信号が送られていることがわかり、その6台をモバイルコアネットワークから切り離したという。

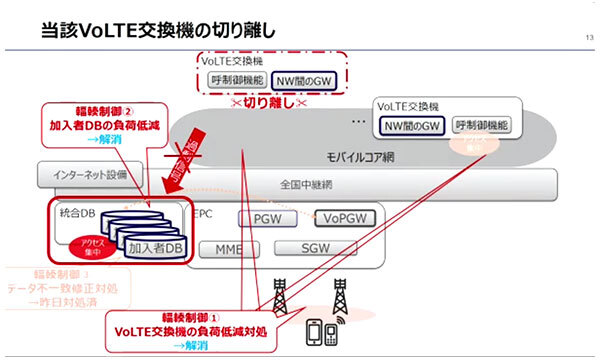

6台のVoLTE交換機を切り離し(7月4日発表)

VoLTE交換機と加入者DBの負荷低減は解消に

これによりネットワークは徐々に復旧に向いはじめ、VoLTE交換機や加入者DBの負荷が低減されていった。この間、並行して50%の流量制御を段階的に下げていきながら作業が進められ、障害前と同水準まで戻り、4日14時51分、無線設備の流量制御を解除した。データ通信と音声通話はほぼ回復したという。KDDIでは、音声通話やデータ通信が利用しづらい場合は、電話機の電源OFF・ONの操作を試すことをすすめている。

「3G時代はここまで大きな障害を聞いたことがないが、スマートフォンは再接続要求など輻輳を起こしやすい、自動化されている部分があり、それが大規模障害につながっている可能性もあるので、しっかりと対策を検討したい。音声通話は夜中の通話がなくても、実際には50分おきに端末側から自動的にアクセスがくる。オールウェイズ・オンと昔よく言っていたが、常に端末がシステムにアクセスしてくる状態がつくられ、それが輻輳や高アクセスな状態の引き金になっている」。

5GやIoTの普及が進むにつれて、処理しなければならないデータ量が莫大に増えることは以前から指摘されていることだ。今回の通信障害でも、事前のシミュレーションやAIなどを使ったシーケンスはうまく働かなかったという。抜本的なシステムやネットワーク、運用の見直しが必要になっている。

例えば、流量制限が50%から30%、20%と下がっていれば復旧に向けて前進していことがわかるだろうし、異常のあるVoLTE交換機の台数が当初より増えたとしても、結果的にデータ通信や音声通話の回復に向かっているのであれば、悪さをしている機器の取り除きに成功したということでもあり、決して悪い情報ではないはずだ。目に見えない通信ネットワークだからこそ、情報提供が少ないと不安は広がる。

KDDIは7月5日16時15分現在のリリースで、事故対策本部会議において7月4日15時00分以降、個人・法人のサービス利用状況とネットワークのトラヒック正常性に問題がないことを、7月5日15時36分に最終確認ししたと発表。緊急通報も接続が可能になった。そして、利用者における通信障害の影響期間を7月2日1時35分頃~7月4日15時00分とした。61時間25分の大規模通信障害となった。

総務省による行政指導の内容やKDDIによる原因究明と再発防止策の策定、補償についてはこれからとなるが、大規模な通信障害が起きた際の広報姿勢についても業界全体で検討すべき課題となるだろう。(BCN・細田 立圭志)

【修正】7月6日にKDDIが「HPに障害情報を掲載した時間」について、「2:52」は誤りで正しくは「3:16」だったと発表したので本文を修正、画像を正しいものに差し替えました。「2:52」は、HPに障害情報を掲載することを決定した時間です。

執行役員 技術統括本部の山本和弘副統括本部長 兼 エンジニアリング推進本部長

(7月4日20時のオンライン会見)

通信障害の発生から7月3日の会見まで

KDDIと沖縄セルラー電話による通信障害では、7月2日1時35分頃、多摩の1拠点におけるコアルータの新旧製品の入れ替え作業で、トラヒックのルートを変更している最中に、VoLTE交換機にアラームが発生した。同様のメンテナンス作業は毎月実施しており、この日だけの特別困難な作業ではなかったという。そして、一部の音声通話が約15分間にわたってつながっていないことが判明(1時50分)。2時に事故対策本部を立ち上げた。

その後、音声トラヒックの切り戻しを実施した後にアクセスが集中し、利用者のスマートフォンなどからの再接続要求が多発したことも重なり、VoLTE交換機で通信が集中・混雑する輻輳(ふくそう)という現象が発生。全国規模の通信障害に広がった。KDDIは、3時16分にホームページで障害情報を発表した。

全国に18台あるVoLTE交換機の負荷を低減するための対処を実施し、「これをすればなんとかネットワークが戻るだろうということで行った。しかし、15時22分に、VoLTE交換機の負荷低減ではおさまらず、加入者DBもあふれて負荷低減作業を行った。17時31分に、加入者DB(データベース)のデータ不一致が原因であることがわかってきたため、データ不一致の修正対処を行い、なんとか少しづつ復旧してきている」と、高橋誠社長は7月3日11時の会見で語っている。

1拠点のコアルーターの交換作業をきっかけとし、VoLTE交換機のトラヒック集中、加入者DBのデータ不一致と次々にトラブルが広がっていった様子がわかる。

3日の会見では、11時に西日本、17時30分に東日本エリアの復旧作業終了予定を発表した。なお、西日本エリアを先行したのは、通信障害で緊急通報(110番、118番、119番)がつながらなくなり、沖縄地方に台風が上陸していたことから、首相官邸の意向を受けた総務省からの指示があったことを明らかにしている。

この復旧作業終了は、復旧のための作業が終わったということでネットワーク環境が元に戻ったことを意味しなかった。引き続き、ネットワークへのデータ流入を50%制限する流量制御を行いながら、試験や検証を行っていたためデータ通信や音声通話がつながりにくい状況は続いた。この点は「復旧作業終了」という言葉をめぐって、ユーザーの受け止め方との違いが生じてしまい、KDDIのアナウンスの仕方に問題があったと言えるだろう。

7月4日の会見で初めてわかったトラブル

さて、4日夜に開かれた会見では、前日の会見後もVoLTE交換機や加入者DBの負荷が予定通りに抑制できていなかったことが明かされた。「想定したレベルまで落ちなかったため時間を要してしまった」と吉村和幸取締役執行役員専務は陳謝した。流量制御をしながら18台のVoLTE交換機の健全性を検証した結果、6台のVoLTE交換機から過剰信号が送られていることがわかり、その6台をモバイルコアネットワークから切り離したという。

これによりネットワークは徐々に復旧に向いはじめ、VoLTE交換機や加入者DBの負荷が低減されていった。この間、並行して50%の流量制御を段階的に下げていきながら作業が進められ、障害前と同水準まで戻り、4日14時51分、無線設備の流量制御を解除した。データ通信と音声通話はほぼ回復したという。KDDIでは、音声通話やデータ通信が利用しづらい場合は、電話機の電源OFF・ONの操作を試すことをすすめている。

スマートフォンによる再接続要求の自動化で輻輳が起きやすくなっている

詳しい原因究明はこれからだが、2021年10月にNTTドコモが引き起こした通信障害に続き、過去最大規模の通信障害が起きた理由について、吉村専務は質疑応答で気になる見解を述べた。「3G時代はここまで大きな障害を聞いたことがないが、スマートフォンは再接続要求など輻輳を起こしやすい、自動化されている部分があり、それが大規模障害につながっている可能性もあるので、しっかりと対策を検討したい。音声通話は夜中の通話がなくても、実際には50分おきに端末側から自動的にアクセスがくる。オールウェイズ・オンと昔よく言っていたが、常に端末がシステムにアクセスしてくる状態がつくられ、それが輻輳や高アクセスな状態の引き金になっている」。

5GやIoTの普及が進むにつれて、処理しなければならないデータ量が莫大に増えることは以前から指摘されていることだ。今回の通信障害でも、事前のシミュレーションやAIなどを使ったシーケンスはうまく働かなかったという。抜本的なシステムやネットワーク、運用の見直しが必要になっている。

広報姿勢は正しかったか

また、KDDIのホームページでは事故直後の7月2日3時から1時間ごとにホームページで通信障害の状況をリリースしていたが、6台のVoLTE交換機が切り離されたことや、流量制限を段階的に下げていることには触れられていなかった。無意味に国民を不安に陥れる必要はないが、悪い情報もいい情報も正確な事実をできる限り公開するのが、「重大な事故」を引き起こした際の広報姿勢の鉄則ではないだろうか。例えば、流量制限が50%から30%、20%と下がっていれば復旧に向けて前進していことがわかるだろうし、異常のあるVoLTE交換機の台数が当初より増えたとしても、結果的にデータ通信や音声通話の回復に向かっているのであれば、悪さをしている機器の取り除きに成功したということでもあり、決して悪い情報ではないはずだ。目に見えない通信ネットワークだからこそ、情報提供が少ないと不安は広がる。

KDDIは7月5日16時15分現在のリリースで、事故対策本部会議において7月4日15時00分以降、個人・法人のサービス利用状況とネットワークのトラヒック正常性に問題がないことを、7月5日15時36分に最終確認ししたと発表。緊急通報も接続が可能になった。そして、利用者における通信障害の影響期間を7月2日1時35分頃~7月4日15時00分とした。61時間25分の大規模通信障害となった。

総務省による行政指導の内容やKDDIによる原因究明と再発防止策の策定、補償についてはこれからとなるが、大規模な通信障害が起きた際の広報姿勢についても業界全体で検討すべき課題となるだろう。(BCN・細田 立圭志)

【修正】7月6日にKDDIが「HPに障害情報を掲載した時間」について、「2:52」は誤りで正しくは「3:16」だったと発表したので本文を修正、画像を正しいものに差し替えました。「2:52」は、HPに障害情報を掲載することを決定した時間です。